ARTÍCULO ORIGINAL

Adaptación y validación al español del Institutional Review Board Researcher Assessment Tool (IRB-RAT)

Spanish adaptation and validation of the Institutional Review Board Researcher Assessment Tool (IRB-RAT)

Joel Christian Roque-Henriquez1,a, Juan Carlos Bazo-Alvarez1,2,3,b, Agueda Muñoz del Carpio Toia4,c, Wilfredo Mormontoy-Laurel1,d

1 Departamento

de Estadística, Demografía, Humanidades y Ciencias Sociales, Facultad de

Ciencias y Filosofía, Universidad Peruana Cayetano Heredia. Lima, Perú.

2 Centro de Estudios de Población, Universidad Católica los

Ángeles de Chimbote (ULADECH). Chimbote, Perú

3 PSYCOPERU Instituto de Investigación, Capacitación y Desarrollo

Psicosocial y Educativo. Lima, Perú.

4 Facultad de Medicina, Universidad Católica de Santa María.

Arequipa, Perú.

a Médico cirujano, maestro en Epidemiología Clínica; b

licenciado en Psicología, especialista en Estadística en Investigación,

maestro en Investigación Epidemiológica; c médico cirujano,

doctora en Medicina; d ingeniero químico, maestro en Salud

Pública.

RESUMEN

Objetivo. Evaluar la confiabilidad y validez del Institutional Review Board Researcher Assessment Tool (IRB-RAT) traducido y adaptado culturalmente para los comités de ética en investigación (CEI) peruanos. Materiales y métodos. El IRB-RAT es un instrumento que determina como son percibidos los CEI por los investigadores en función a ocho factores, mediante dos formatos: 1) importancia en el trabajo del investigador y 2) descriptivo del CEI evaluado. Su versión original en inglés se tradujo y adaptó culturalmente al español, con el apoyo de expertos y representantes de la población objetivo. Luego, según las respuestas de 113 usuarios, se identificaron y eliminaron los ítems heterogéneos hasta obtener una versión final de 29 ítems. La confiabilidad de esta versión se revisó mediante α de Cronbach y coeficiente omega, su validez de estructura interna mediante un análisis factorial confirmatorio con el método de mínimos cuadrados no ponderados. Resultados. La traducción y adaptación cultural cumplió con los pasos recomendados internacionalmente. La confiabilidad a nivel de los ocho factores fue moderada para el formato 1 (0,67<α<0,89; 0,71<ω<0,89) y alta para el formato 2 (0,83<α<0,92; 0,85<ω<0,92). La validez de contenido fue alta a nivel de ítems y moderada para los factores. La validez de estructura interna fue buena para el formato 1 (AGFI=0,97, GFI=0,97, NFI=0,97, RMR=0,04) y moderadamente buena para el formato 2 (AGFI=0,99, GFI=0,99, NFI=0,99, RMR=0,10). Conclusión. Nuestra adaptación al español del IRB-RAT tiene confiabilidad y validez suficientes para asistir en la mejora continua de los CEI del medio peruano y otros similares de habla hispana.

Palabras clave: Comités de Ética en Investigación; Encuestas y Cuestionarios; Análisis Factorial (fuente: DeCS BIREME).

ABSTRACT

Objective. To assess the reliability and validity of the translated and culturally-adapted Institutional Review Board Researcher Assessment Tool (IRB-RAT) for Peruvian research ethics committees (RECs). Materials and Methods. The IRB-RAT is an instrument that determines how RECs are perceived by researchers based on eight factors, using two formats: 1) importance in the work of the researcher and 2) descriptive of the REC being evaluated. Its original English version was translated and culturally adapted into Spanish, with the support of experts and representatives of the target population. Then, according to the responses of 113 users, the heterogeneous items were identified and eliminated until a final version of 29 items was obtained. The reliability of this version was reviewed using Cronbach’s α and omega coefficient, its internal structure validity through a confirmatory factor analysis with the unweighted least squares method. Results. Translation and cultural adaptation complied with internationally recommended steps. Reliability at the level of the eight factors was moderate for format 1 (0.67<α<0.89; 0.71<ω<0.89) and high for format 2 (0.83<α<0.92; 0.85<ω<0.92). Content validity was high at item level and moderate for factors. Internal structure validity was good for format 1 (AGFI=0.97, GFI=0.97, NFI=0.97, RMR=0.04) and moderately good for format 2 (AGFI=0.99, GFI=0.99, NFI=0.99, RMR=0.10). Conclusions. Our Spanish adaptation of the IRB-RAT has sufficient reliability and validity to assist in the continuous improvement of the RECs in Peru and other Spanish-speaking countries.

Keywords: Research Ethics Committees; Surveys and questionnaires; Factor analysis (source: MeSH NLM).

INTRODUCCIÓN

En los últimos años, en América Latina y el resto del mundo, se ha hecho evidente una tendencia creciente en el número de publicaciones científicas e investigadores por millón de habitantes (1,2). Si bien la contribución peruana a la producción científica mundial es escasa, ésta creció en 134 % del 2005 al 2014 (1). En respuesta al aumento de la producción científica en nuestro país y a un mayor interés sobre la misma (3-4), se están constituyendo nuevos comités de ética en investigación (CEI). Los CEI requieren estar en constante capacitación y revisión de sus procesos internos, para cumplir con su rol de entes observadores de la idoneidad y transparencia de las investigaciones (5). En otras palabras, los CEI están comprometidos con su propia mejora continua.

A nivel internacional, los estudios señalan diversas barreras potenciales para el funcionamiento adecuado de los CEI, especialmente en países de bajos y medianos ingresos. Entre estas barreras podemos listar: la insuficiente diversidad de miembros, la falta de su adecuado entrenamiento, la no dedicación exclusiva de los miembros, el insuficiente apoyo financiero y de otros recursos, la falta de independencia del CEI, y la escasa o nula supervisión de los estudios que se han aprobado (6-9). En el mundo ya existen varias iniciativas gubernamentales y privadas de acreditación de los CEI (10-13), que ayudan a gestionar la superación de dichas barreras. Sin embargo, en países de bajos y medianos ingresos tales iniciativas aún son poco viables debido a la inversión de recursos humanos y financieros necesarios (14).

Algunos procesos de acreditación incluyen como un paso importante la autoevaluación realizada por el CEI (10,12), para la cual un cuestionario validado es una herramienta poderosa. A nivel mundial, diferentes instituciones han elaborado instrumentos que evalúan el desempeño de los CEI (15-17); no obstante, pocos de ellos han seguido la metodología recomendada para validación de instrumentos (18,19). El Institutional Review Board Researcher Assessment Tool (IRB-RAT) (15), es un cuestionario de autoevaluación, que permite a los CEI recabar información de sus usuarios (los investigadores) y, con base en ella, realizar acciones de mejora continua cuya utilidad práctica ya ha sido demostrada en estudios previos (20-22). A pesar de sus bondades y utilidad, actualmente en Perú y el resto de Latinoamérica no existe una versión del IRB-RAT adaptada a nuestro idioma, cultura y contexto.

En ese sentido, el presente estudio tuvo como objetivo la validación del IRB-RAT previamente sometido a adaptación cultural para CEI peruanos, así como evaluar su confiabilidad.

MÉTODOS

DISEÑO DEL ESTUDIO

El presente es un estudio psicométrico de adaptación y validación que contempló dos etapas: a) traducción y adaptación cultural del IRB-RAT y b) validación del cuestionario traducido al español.

POBLACIÓN Y MUESTRA

La población diana son los investigadores usuarios de los CEI peruanos. La población de estudio fueron los investigadores usuarios de los CEI del Instituto Nacional de Salud (INS), Instituto Regional de Enfermedades Neoplásicas «Dr. Luis Pinillos Ganoza» (IREN Norte) y de la Universidad Católica de Santa María (UCSM) de Arequipa. El marco muestral estuvo conformado por los investigadores usuarios de los CEI del 2015 en adelante. El criterio de inclusión fue ser investigador usuario de cualquiera de los CEI participantes del 2015 en adelante. Se consideraron dos criterios de exclusión: investigador integrante del equipo de investigación y rehusarse a participar del estudio. La unidad de análisis fue un cuestionario del IRB-RAT respondido. Se consideró como criterio de eliminación aquellos cuestionarios cumplimentados con menos del 90% de toda la información solicitada.

INSTRUMENTO

El IRB-RAT es un instrumento que determinar cómo los investigadores perciben a los CEI. Así, cada investigador (usuario) evalúa al CEI en función a 45 indicadores (ítems) agrupados en ocho factores: 1) Indicios de justicia procedimental del CEI, 2) Indicios de justicia interpersonal del CEI (respeto, cooperación), 3) Indicios de imparcialidad del CEI (falta de sesgo), 4) Indicios de sensibilidad en pro de la ciencia del CEI, 5) Indicios de competencia del CEI, 6) Divulgación por el CEI, 7) Funcionamiento formal, estructura, y composición del CEI, y 8) Indicios que los derechos de los participantes humanos están siendo defendidos por el CEI.

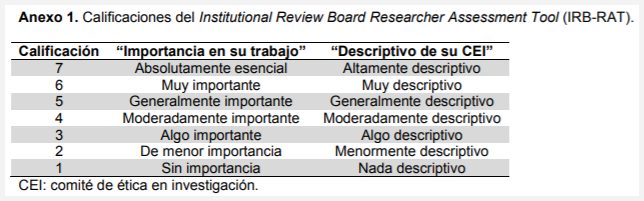

El IRB-RAT tiene dos formatos, uno para determinar cuán importante es cada uno de los indicadores para que el investigador pueda realizar mejor su trabajo (formato 1: «importancia en su trabajo») y otra para determinar cuán descriptivo del CEI evaluado es cada uno de dichos indicadores (formato 2: «descriptivo de su CEI»); ambos usando escalas tipo Likert (Anexo 1). Existen dos formas de aplicar el IRB-RAT: a) La versión A de «dos pasadas», en la primera el investigador responde los 45 ítems del formato 1, y en la segunda responde los mismos ítems y en el mismo orden el formato 2 (en la práctica, esta versión es más larga toda vez que requiere que se respondan en total 90 ítems), b) La versión B «de una sola pasada», en la cual el investigador da dos respuestas consecutivas, una para «importancia en su trabajo» y otra para «descriptivo de su CEI», por cada ítem (15).

VARIABLES DEL ESTUDIO

Aparte de los ítems del IRB-RAT, también se midieron las siguientes variables de los investigadores encuestados (usuarios del CEI): edad, sexo, profesión, área de investigación, número de publicaciones en revistas indizadas en los últimos siete años, si ha seguido algún curso de ética en investigación y CEI del cual es usuario el investigador.

PROCEDIMIENTO

Primera etapa: traducción y adaptación cultural

En primer lugar, la traducción literal al español de la versión B del IRB-RAT (disponible en: www.ethicsresearch.com y solicitado en formato Word al siguiente correo electrónico: pkspiegel@comcast.net), fue realizada por dos traductoras bilingües independientes cuya lengua materna es el español. Una de las traductoras, miembro de un CEI, conocía los objetivos del estudio. La otra traductora, autorizada por el Colegio de Traductores del Perú para firmar traducciones certificadas, no contaba con conocimientos previos del cuestionario y desconocía los objetivos del estudio. Teniendo como insumo ambas traducciones, el equipo de investigación y la traductora miembro de un CEI identificaron y discutieron las discrepancias entre las versiones traducidas hasta llegar a un consenso.

El siguiente paso fue la traducción literal inversa de la versión consensuada, realizada por dos traductoras bilingües independientes cuya lengua materna es el inglés y con amplia experiencia en traducción de instrumentos en salud. Ambas entregaron sus traducciones (retro-traducciones) con observaciones semánticas y conceptuales entre su versión y la versión original.

Posteriormente, se procedió a la consolidación por un comité de expertos, el cual estuvo conformado por dos ex-presidentes de CEI, un ex-miembro de un CEI, un miembro actual de un CEI y el investigador principal del estudio. Los insumos utilizados fueron la traducción literal al español consensuada, y las dos retro-traducciones con sus observaciones semánticas y conceptuales. El producto de este comité fue un cuestionario consolidado pre-final adaptado al español.

Para concluir con esta primera etapa, se realizó una prueba piloto con 26 investigadores registrados en el Registro Peruano de Ensayos Clínicos (REPEC) del INS y en once miembros de los CEI participantes, quienes contestaron y comentaron el cuestionario consolidado pre-final. Con la información allí recabada se mejoró la traducción y la adaptación cultural. Por ejemplo, se agregó la opción de respuesta «no sé» a la pregunta ¿cuán descriptivo es este enunciado de su CEI?, y se determinó que el tiempo promedio requerido para completarlo fue de 15,5 ± 2,3 minutos.

Segunda etapa: validación del cuestionario traducido al español

Mediante una ficha de evaluación elaborada por el equipo de investigación, tres expertos (un ex-miembro de un CEI, un miembro actual de un CEI y una evaluadora de ensayos clínicos) evaluaron la validez de contenido del cuestionario final obtenido en la primera etapa.

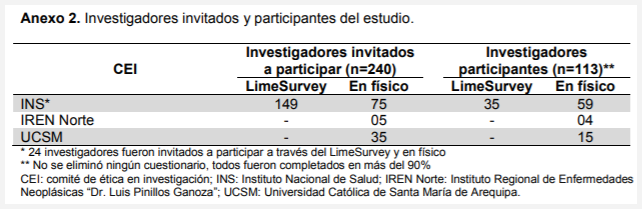

Luego, el cuestionario fue entregado a 240 investigadores usuarios del CEI del INS, IREN Norte y UCSM a través del programa LimeSurvey y/o entrega física entre el 15 de julio y 03 de setiembre de 2016, en ambos casos se solicitó leer primero una «hoja informativa para los participantes del estudio». De ellos, un total de 113 respondieron efectivamente, lo que representa una tasa de respuesta del 47,1% (Anexo 2). Con estos datos se detectaron y depuraron los ítems heterogéneos de cada factor procurando no alterar el contenido de los mismos (su representatividad de dominio), quedando una versión más corta del IRB-RAT de sólo 29 ítems. Esta es la versión definitiva y recomendada para uso local, cuya confiabilidad y validez aquí reportamos. Todos los materiales descritos en esta sección de procedimiento pueden ser solicitados por correo electrónico.

ANÁLISIS ESTADÍSTICO

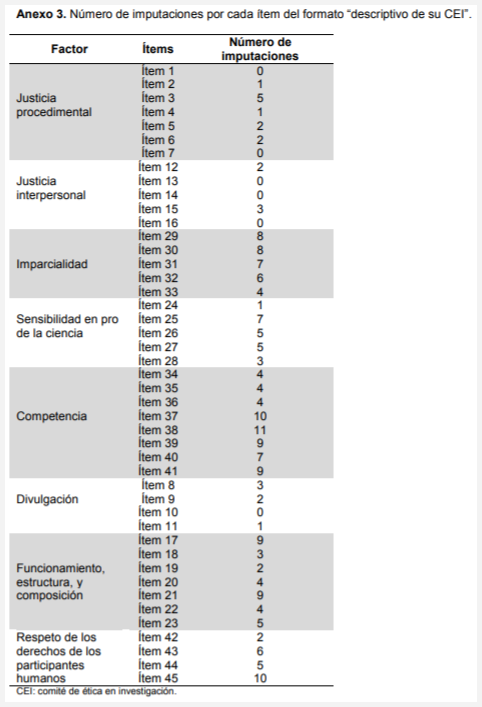

Los 45 ítems fueron respondidos en su totalidad tanto para «importancia en su trabajo» y «descriptivo de su CEI», para este último las respuestas «no sé» fueron catalogadas como datos perdidos. Con la información obtenida de los cuestionarios se elaboró una base de datos y la calidad de los mismos se controló mediante análisis exploratorio. Luego, se realizó imputación simple de los datos perdidos por el método de la media (Anexo 3).

Se realizó análisis descriptivo de las características de los participantes del estudio, teniendo en cuenta las variables arriba señaladas, así como de los ítems del cuestionario IRB-RAT. Para ello nos servimos de porcentajes para variables categóricas y de medias, desviaciones estándar, medianas, asimetría y curtosis para variables cuantitativas. La validez de contenido del cuestionario fue evaluada mediante el coeficiente V de Aiken, usando la información proporcionada por los tres expertos mediante la ficha de evaluación ya mencionada. La confiabilidad de cada formato del cuestionario se estimó en función a la consistencia interna, calculando el alfa de Cronbach y coeficiente omega para cada factor. Simultáneamente, analizamos la homogeneidad de los ítems mediante matrices de correlación ítem-ítem (correlaciones policóricas) e ítem-resto.

Utilizando información proveniente del análisis de consistencia interna, se detectaron aquellos ítems más heterogéneos del IRB-RAT, generando así una versión corta, pero con mejores características psicométricas para nuestra población objetivo. Para evaluar su validez de estructura interna, recurrimos a un análisis factorial confirmatorio (AFC), usando mínimos cuadrados no ponderados como método de estimación. Dicho método es válido ante el incumplimiento de supuestos como la normalidad multivariante o la medición realizada con ítems categóricos (23), como es el caso del presente estudio. La bondad de ajuste del modelo de medida se verificó con i) el índice de bondad de ajuste absoluto (GFI), el cual es aceptable cuando su valor es mayor a 0,95 (24); ii) la raíz del residuo promedio (RMR), que es adecuada cuando se reporta menor a 0,05 (25); iii) el índice de ajuste normal (NFI), que se espera sea mayor a 0,90 en situaciones ideales (26); iv) el índice de parsimonia basado en NFI (PNFI), ideal cuando es mayor a 0,5 (27) y v) el índice de bondad de ajuste ajustado (AGFI), el cual es aceptable cuando no es menor de 0,85 (28). Todos los análisis estadísticos fueron realizados con los paquetes Stata® versión 12 (StataCorp, College Station, Texas, USA), Amos versión 22 (SPSS, IBM, New York, USA) y R versión 3.1.2.

ASPECTOS ÉTICOS

Se obtuvo la autorización de la Oficina General de Investigación y Transferencia Tecnológica del INS para acceder al registro de investigadores del REPEC y poder usar el programa LimeSurvey desde su servidor. Del mismo modo, se contó con la autorización de participación de los tres CEI seleccionados. Todos los participantes que cumplimentaron el cuestionario fueron informados sobre el estudio, enfatizando que su participación sería voluntaria y que se mantendría la confidencialidad de los datos brindados. Este estudio fue aprobado por el Comité Institucional de Ética para Humanos de la Universidad Peruana Cayetano Heredia con RCEI-14.

RESULTADOS

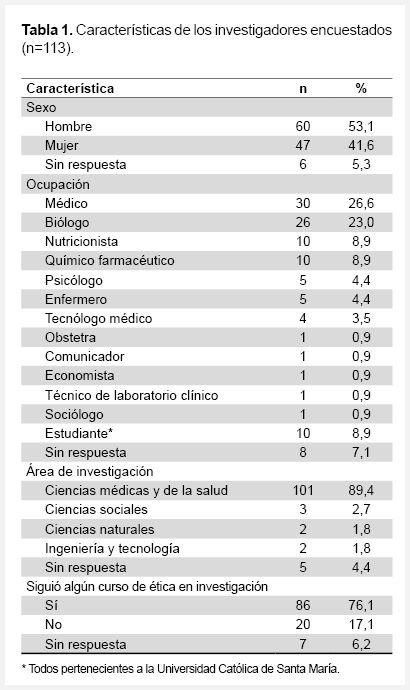

La Tabla 1 muestra las características de los 113 participantes de la segunda etapa del estudio. Cabe destacar que 53,1% eran hombres y la media de edad fue de 41,4 ± 10,2 años. Las tres ocupaciones principales fueron médicos (26,6%), biólogos (23,0%) y nutricionistas (8,9%); y el 89,4% eran investigadores de ciencias médicas y de la salud. El 76,1% había seguido algún curso de ética en investigación.

Los descriptivos para cada ítem se muestran en el Anexo 4. En general, las medias de los ítems «importancia en su trabajo» fueron más altas que las de los ítems «descriptivos de su CEI». Todos los ítems presentaron asimetría negativa, y sólo el ítem 11 correspondiente a «descriptivo de su CEI» tuvo distribución normal.

El acuerdo de los expertos, mediante el coeficiente V de Aiken, al evaluar cada ítem es visible en el Anexo 5. Respecto a redacción clara y precisa, para cada ítem fue ≥ 0,7; excepto para el ítem 44 cuyo acuerdo fue de solo 0,3. Respecto a coherencia con la categoría y ser adecuado para el instrumento, para cada ítem fue ≥ 0,7. El acuerdo total más bajo fue de 0,6, correspondiente al ítem 44.

En general las correlaciones ítem-ítem (policóricas) de los 29 ítems finales de nuestra adaptación del IRB-RAT de 45 ítems (Anexo 6) fueron más altas en el formato «descriptivos de su CEI" que en "importancia en su trabajo» (Anexo 7). Para ambos formatos la mayoría de las correlaciones entre ítems tuvieron valores inferiores a 0,9. Los valores más bajos de las correlaciones ítem-resto para «importancia en su trabajo» correspondieron al factor divulgación que estuvieron entre 0,35 y 0,59 (0,49 ± 0,12). Respecto a las correlaciones ítem-resto para «descriptivo de su CEI», los valores más bajos correspondieron al factor respeto de los derechos de los participantes humanos que estuvieron entre 0,53 y 0,77 (0,69 ± 0,14) (Tabla 2). En la misma Tabla 2 se examina la confiabilidad de las ocho escalas del cuestionario mediante el alfa de Cronbach y coeficiente omega, la consistencia fue un poco menor para «importancia en su trabajo» (0,67<α<0,89; 0,71<ω<0,89), que para «descriptivo de su CEI» (0,83<α<0,92; 0,85<ω<0,92).

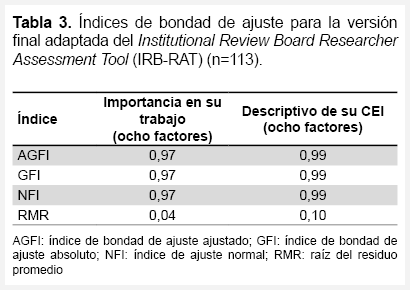

Los resultados del AFC son visibles en la Tabla 3 y las Figuras 1 y 2. Para el formato «importancia en su trabajo», los coeficientes β estandarizados entre dimensiones e indicadores estuvieron entre 0,45 y 0,91, y los β estandarizados entre dimensiones entre 0,33 y 0,93. Para el formato «descriptivos de su CEI», los coeficientes β estandarizados entre dimensiones e indicadores estuvieron entre 0,61 y 0,94, y los β estandarizados entre dimensiones entre 0,75 y 0,96. Los índices de bondad de ajuste AGFI, GFI y NFI son altos para ambos formatos, mientras que el RMR es un poco elevado para el formato «descriptivo de su CEI» (RMR=0,10).

DISCUSIÓN

La metodología seguida en el presente estudio cumplió con los pasos recomendados internacionalmente para la traducción y adaptación cultural de instrumentos psicométricos: 1) Traducción-retraducción por personas bilingües, 2) Consolidación por un comité de expertos, y 3) Comprobación de su comprensión y de su aceptabilidad en el grupo objetivo (18,19). Más aún, la información estadística permitió completar el proceso de adaptación lográndose una versión más corta que la original (29 ítems, ver Anexo 7), válida y consistente para nuestra población.

Los ítems del formato «importancia en su trabajo» mostraron un notorio «ceiling effect» y tuvieron medias superiores a sus pares «descriptivo de su CEI», resultado esperado y coherente con los hallazgos en publicaciones previas (15,21). En teoría, éste es un indicador de la brecha que existe entre la expectativa de los usuarios y su satisfacción con el desempeño de los CEI al momento del estudio. En la práctica, esto enseña cómo puede trabajarse esta adaptación del IRB-RAT como instrumento para la mejora continua. Primero, el CEI puede hacer una evaluación de línea de base usando ambos formatos. Luego, sabiendo que la «importancia en su trabajo» no cambiará mucho en el tiempo, las siguientes evaluaciones pueden realizarse sólo con el formato «descriptivo de su CEI». De hecho, la distribución de los valores de sus ítems muestra que dicho formato brinda un mayor rango dentro del cual poder medir el cambio a través del tiempo. Es decir, que luego de tener la línea de base del CEI y realizar una intervención de mejora, el formato «descriptivo de su CEI» es suficiente para evaluar el impacto posintervención.

La confiabilidad de nuestra adaptación del IRB-RAT es buena en ambos formatos (29). Si los CEI desean conocer cuáles factores son más «importantes» para sus usuarios, sus evaluaciones serán confiables siempre que se realicen en forma grupal; esto debido al rango de los alfa de Cronbach y coeficientes omega para el formato «importancia en su trabajo» (30). Para el formato «descriptivo de su CEI» la confiabilidad es mucho más alta, lo cual es una ventaja y habilita evaluaciones confiables, incluso a nivel individual (por usuario). Sin embargo, dado el diseño de nuestro estudio, aún no es posible brindar mayores detalles sobre la invarianza de medida longitudinal que permitan saber con exactitud qué proporción del cambio en el tiempo se debe al mismo instrumento (23). Adicionalmente, un cuidado que deberá tener el CEI al calificar y comparar los resultados del IRB-RAT a nivel de factores es el de usar alguna transformación tipificada sobre sus puntajes crudos, dado que la cantidad de ítems es variable de factor a factor (ver Figuras 1 y 2).

La validez de contenido para cada uno de los ítems fue buena, lo que es particularmente visible en el acuerdo manifiesto de los expertos. Sin embargo, la representatividad de dominio se vio un tanto reducida a nivel de cada factor tras la eliminación de ítems. No obstante lo anterior, es importante destacar que dicha reducción derivó de la evidencia de heterogeneidad de los ítems; en otras palabras, de inconsistencias puntuales detectadas en el cómo los mismos usuarios percibían o no cada uno de los indicadores como importantes o característicos de su CEI. Lo anterior implica que nuestra versión adaptada del IRB-RAT es válida y consistente desde la visión de los expertos y, especialmente, de los usuarios de los CEI, quienes son la población objetivo de quienes se espera valorar en el futuro su opinión o satisfacción.

En general, la validez de estructura interna es buena para el formato «importancia para su trabajo» y moderadamente buena para el formato «descriptivo de su CEI». En concreto, el único indicador de bondad de ajuste que no alcanzó el valor ideal esperado (<0,05) fue el RMR=0,10 para el formato «descriptivo de su CEI». Como es sabido, el RMR provee una medida de la magnitud promedio de los residuales entre la matriz de covarianzas/correlaciones observada y la reproducida por el modelo de medida (25). Así y a pesar del ideal estándar <0,05, se sabe que el valor RMR puede crecer cuando la muestra es pequeña, cuando hay muchos indicadores por factor o muchos factores, o cuando las cargas factoriales son moderadas o mixtas (25); todas éstas circunstancias se deben atender para hacer una correcta interpretación de su valor. En nuestro estudio, la muestra no alcanzó el tamaño ideal (113 es un tamaño moderado), el número de factores fue relativamente elevado (ocho) y las cargas factoriales fueron mixtas (mezcla de moderadas y altas). Dicho esto, consideramos que el valor RMR=0,10 no refleja exclusivamente características propias del instrumento y, por ello, es todavía admisible.

Hemos detectado algunas fortalezas y limitaciones de nuestro estudio que creemos preciso destacar. La principal fortaleza radica en la primera fase del estudio que se centró en la traducción y adaptación cultural del instrumento. En ella se invirtió una gran cantidad de tiempo y esfuerzo que es difícil de reproducir, por lo que su producto es especialmente valorado. Otra fortaleza es que un instrumento más corto como el aquí adaptado (29 en vez de 45 ítems) es más fácil de aplicar e interpretar, esto último especialmente útil cuando los CEI necesiten trabajar con indicadores puntuales para enfocar sus intervenciones de mejora.

Entre las limitaciones principales podemos destacar el no haber incluido un mayor número de CEI y no haber logrado un tamaño muestral más grande (sólo logramos 3,9 encuestados por ítem). Sin embargo, es preciso declarar que la colaboración de los CEI es en general limitada por razones administrativas y que la tasa de respuesta de los encuestados fue menor al 50%, aunque superior a lo reportado en investigaciones previas (15,20). Aun así, consideramos que hemos alcanzado un tamaño mínimo necesario para cumplir el objetivo propuesto. Finalmente, los usuarios de estos CEI son en su mayoría investigadores en ciencias de la salud, lo que acota la generalización formal de los resultados del estudio a dicho grupo. Sin embargo, es justo también resaltar que en nuestro país éste es el perfil de la mayoría de los usuarios actuales de los servicios de los CEI.

Concluimos que nuestra adaptación del IRB-RAT tiene la confiabilidad y validez suficientes para poder ser usada en los CEI del medio de investigación peruano y otros similares de habla hispana.

Agradecimientos: Los autores agradecen la valiosa colaboración de Duilio Jesús Fuentes Delgado, Ana María Burga Vega y Margarita Cynthia Posso Rivera.

Contribuciones de los autores: La idea original de este estudio es de JCRH, quien además fue el responsable del trabajo de campo y del análisis estadístico (con la guía de JCBA y WML). JCRH, JCBA, AMCT y WML han participado en el diseño del estudio, la redacción del artículo y han aprobado su versión final.

Fuentes de financiamiento: El presente estudio ha sido autofinanciado por JCHR. La participación de JCBA y WML ha sido parcialmente financiada por el Departamento de Estadística, Demografía, Humanidades y Ciencias Sociales, de la Universidad Peruana Cayetano Heredia, como parte de las actividades docentes del Programa de Segunda Especialización en Estadística en Investigación. Parte del tiempo de JCBA invertido en este proyecto fue también financiado por la Universidad Católica los Ángeles de Chimbote (ULADECH).

Conflictos de interés: Todos los autores declaran que no tienen conflicto de interés alguno.

REFERENCIAS BIBLIOGRÁFICAS:

1. United Nations Educational, Scientific and Cultural Organization. UNESCO science report towards 2030 [Internet]. Paris: UNESCO; 2015 [citado el 15 de noviembre de 2017]. Disponible en: http://unesdoc.unesco.org/images/0023/002354/235406e.pdf.

2. Consejo Nacional de Ciencia, Tecnología e Innovación Tecnológica. I Censo Nacional de Investigación y Desarrollo a Centros de Investigación 2016 [Internet]. Lima: CONCYTEC; 2017 [citado el 15 de noviembre de 2017]. Disponible en: https://portal.concytec.gob.pe/images/publicaciones/censo_2016/libro_censo_nacional.pdf.

3. Consejo Nacional de Ciencia, Tecnología e Innovación Tecnológica. Política nacional para el desarrollo de la ciencia, tecnología e innovación tecnológica - CTI [Internet]. Lima: CONCYTEC; 2016 [citado el 16 de noviembre de 2017]. Disponible en: https://portal.concytec.gob.pe/index.php/publicaciones/politica-nacional-de-cti.

4. Perú, Congreso de la República. Ley Nº 30220: Ley Universitaria. Lima: Congreso de la República; 2014.

5. Adams P, Kaewkungwal J, Limphattharacharoen C, Prakobtham S, Pengsaa K, Khusmith S. Is your ethics committee efficient? Using "IRB Metrics as a self-assessment tool for continuous improvement at the Faculty of Tropical Medicine, Mahidol University; Thailand. PLoS ONE. 2014;9(11):e113356. doi: 10.1371/journal.pone.0113356.

6. Silaigwana B, Wassenaar D. Biomedical research ethics committees in Sub-Saharan Africa: A collective review of their structure, functioning, and outcomes. J Empir Res Hum Res Ethics. 2015;10(2):169-84.

7. Sleem H, El-Kamary S, Silverman H. Identifying structures, processes, resources and needs of research ethics committees in Egypt. BMC Medical Ethics. 2010;11:12. doi: 10.1186/1472-6939-11-12.

8. Gonorazky S. Comités de Ética independientes para la investigación clínica en la Argentina - evaluación y sistema para garantizar su independencia. Medicina (Buenos Aires). 2008;68(2):113-19.

9. Fuentes D, Revilla D. Acreditación de Comités de Ética en Investigación, como parte de un proceso. An Fac Med Lima. 2007;68(1):67-74.

10. Forum for Ethical Review Committees in the Asian and Western Pacific Region [Internet]. Bangkok: SIDCER Recognition Programme; 2017. [citado el 10 de diciembre de 2017]. Disponible en: http://www.fercap-sidcer.org/recog.php.

11. Association for the Accreditation of Human Research Protection Programs. The value of accreditation [Internet]. Washington, DC: AAHRPP; 2017. [citado el 11 de diciembre de 2017]. Disponible en: http://www.aahrpp.org/.

12. National Health Service. Accreditation process for NHS Research Ethics Committees (R ECs) [Internet]. Londres: NHS; 2017. [citado el 11 de diciembre de 2017]. Disponible en: https://www.nhmrc.gov.au/_files_nhmrc/file/health_ethics/hrecs/UK_NHS_Accreditation_Process_vers_3_22_05_20082.pdf.

13. National Health Research Ethics Council [Internet]. República de Sudáfrica: National Health Research Ethics Council; 2017. [citado el 11 de diciembre de 2017]. Disponible en: http://www.nhrec.org.za/.

14. Silverman H, Sleem H, Moodley K, Kumar N, Naidoo S, Subramanian T, et al. Results of a self-assessment tool to assess the operational characteristics of research ethics committees in low-and middle-income countries. J Med Ethics. 2015;41(4):332-37.

15. Keith-Spiegel P, Koocher G. What scientists want from their Research Ethics Committee. J Empir Res Hum Res Ethics. 2006;1(1):67-82.

16. Sleem H, Abdelhai R, Al-Abdallat I, Al-Naif M, Gabr H, Kehil E, et al. Development of an accessible self-assessment tool for Research Ethics Committees in developing countries. J Empir Res Hum Res Ethics. 2010;5(3):85-98.

17. Stanford University. IRB - CQI surveys and metrics [Internet]. California: Standford University; 2017 [citado el 21 de diciembre de 2017]. Disponible en: http://humansubjects.stanford.edu/new/cqi/surveys_metrics.html.

18. Ramada-Rodilla J, Serra-Pujadas C, Delclós-Clanchet G. Adaptación cultural y validación de cuestionarios de salud: revisión y recomendaciones metodológicas. Salud Publica Mex. 2013;55(1):57-66.

19. Validación de cuestionarios. En: Argimon J., Jiménez J. Métodos de investigación clínica y epidemiológica. 4a ed. Barcelona, España: Elsevier; 2013. p. 200-10.

20. Reeser J, Austin D, Jaros L, Mukesh B, McCarty C. Investigating perceived Institutional Review Board quality and function using the IRB researcher assessment tool. J Empir Res Hum Res Ethics. 2008;3(1):25-34.

21. Chenneville T, Menezes L, Bylsma L, Mann A, Kosambiya J, Baxi R. Assessing Institutional Ethics Committees in India using the IRB-RAT. J Empir Res Hum Res Ethics. 2014;9(4):50-9.

22. Hall D, Hanusa B, Ling B, Stone R, Switzer G, Fine M, et al. Using the IRB Researcher Assessment Tool to guide quality improvement. J Empir Res Hum Res Ethics. 2015;10(5):460-9.

23. Brown T. Confirmatory factor analysis for applied research. 2da ed. New York: Guilford Publications; 2015.

24. Beauducel A, Wittmann W. Simulation study on fit indexes in CFA based on data with slightly distorted simple structure. Structural Equation Modeling: A Multidisciplinary Journal. 2005;12(1):41-75.

25. Anderson J, Gerbing D. The effect of sampling error on convergence, improper solutions, and goodness-of-fit indices for maximum likelihood confirmatory factor analysis. Psychometrika. 1984;49(2):155-73.

26. Hu L, Bentler P. Cutoff criteria for fit indexes in covariance structure analysis: Conventional criteria versus new alternatives. Structural Equation Modeling: A Multidisciplinary Journal. 1999;6(1):1-55.

27. Schermelleh-Engel K, Moosbrugger H, Müller H. Evaluating the fit of structural equation models: Tests of significance and descriptive good-ness-of-fit measures. Methods of Psychological Research. 2003;8(2):23-74.

28. Ullman JB, Bentler PM. Structural Equation Modeling. Handbook of Psychology. 1st ed. Estados Unidos: Wiley; 2003.

29. Nunnally J, Bernstein I. Psychometric theory. 3a ed. Estados Unidos: McGraw-Hill; 1994.

30. Aiken LR. Test Psicológicos y Evaluación. 11a ed. México: Pearson Prentice Hall; 2003.

ANEXOS

Correspondencia:

Joel Christian Roque-Henriquez

Departamento de Estadística, Demografía, Humanidades y Ciencias Sociales;

Facultad de Ciencias y Filosofía, Universidad Peruana Cayetano Heredia;

Lima, Perú.

Dirección: Manzana K Lote 11B - Urbanización Mártires del Sutep - Los

Olivos, Lima - Perú.

Teléfono: 940430215

Email:

joel.roque@upch.pe

Recibido: 18/01/2018

Aprobado: 01/08/2018

En línea: 25/09/2018